Temps de lecture : 2mn15

Hello,

ByteDance vient de sortir un modèle vidéo qui affole tout le monde.

Pendant ce temps, un modèle chinois inconnu a dupé toute l'industrie sous un faux nom, et OpenAI offre le coding IA à tout le monde.

En Focus, on vous explique pourquoi Seedance 2.0 est bien plus qu'un outil vidéo.

Théo & Nathanaël

ByteDance, la maison-mère de TikTok, vient de lâcher une bombe.

Seedance 2.0 ne génère pas juste de la vidéo. Il génère du cinéma.

L'essentiel :

Le modèle produit de la vidéo avec audio synchronisé nativement — musique, bruits d'ambiance, dialogues — directement depuis un prompt texte. Pas de post-production.

Il gère le multi-plans, les transitions, et le lip-sync en 8 langues avec une précision au phonème près.

Un réalisateur avec 7 ans d'expérience a déclaré que 90 % de ses compétences peuvent déjà être remplacées par le modèle.

Elon Musk a commenté sur X : "This is happening too fast."

Les marchés ont réagi violemment. Les actions d'entreprises IA chinoises ont bondi de 20 à 34 % en une journée.

ByteDance a dû suspendre sa fonctionnalité de génération vocale à partir d'une simple photo de visage. Trop de risques de deepfakes.

Le parallèle avec DeepSeek est frappant. Même origine (Chine), même effet de surprise, même onde de choc sur les marchés. Sauf que cette fois, c'est la vidéo qui bascule.

Pendant que tout le monde regardait ailleurs, un modèle inconnu a discrètement grimpé dans tous les classements.

L'essentiel :

Avant son lancement officiel, le modèle avait été testé en douce sur OpenRouter sous le pseudonyme "Pony Alpha." Résultat : 40 milliards de tokens traités dès le premier jour.

Il affiche 77,8 % sur SWE-bench Verified, un benchmark de référence pour le code. C'est comparable aux meilleurs modèles occidentaux.

Et surtout : il coûte 5 à 8 fois moins cher que Claude Opus 4.6. Environ 1 $/million de tokens en entrée, contre 5 $ pour Anthropic.

Zhipu AI est devenue la première entreprise d'IA "fondation model" cotée en bourse, après une IPO à Hong Kong qui a levé 558 millions de dollars.

Un modèle de classe mondiale, sans une seule puce Nvidia, 5 fois moins cher, lancé par une boîte que personne ne connaissait il y a six mois.

L'embargo sur les puces n'a clairement pas fonctionné comme prévu.

OpenAI démocratise l'accès au code IA.

L'essentiel :

Le 12 février, OpenAI a lancé GPT-5.3-Codex-Spark, une version allégée de son modèle de code phare, accessible gratuitement à tous les utilisateurs de ChatGPT.

Jusqu'ici, les modèles de code avancés étaient réservés aux abonnés payants (20 à 200 $/mois). Spark change la donne.

C'est le premier résultat concret du partenariat à 10 milliards de dollars entre OpenAI et Cerebras annoncé en janvier.

L'idée : deux modes complémentaires. Spark pour l'itération rapide (prototypage, UI, corrections), Codex complet pour les tâches lourdes de raisonnement.

Disponible en preview pour les utilisateurs ChatGPT Pro via l'app Codex, le CLI et VS Code.

Après les pubs dans ChatGPT, OpenAI ouvre le robinet de l'autre côté. L'objectif est clair : garder les utilisateurs gratuits dans l'écosystème, même si ça signifie donner plus.

Focus : Pourquoi Hollywood devrait avoir peur

Seedance 2.0 n'est pas "juste" un modèle vidéo de plus.

C'est le premier à combiner vidéo, audio natif, multi-plans et lip-sync multilingue dans un seul et même modèle.

Et il arrive avec un avantage stratégique que personne d'autre n'a.

À suivre :

Ce que Seedance fait (vraiment)

L'avantage ByteDance

Le problème que personne ne veut voir

Ce que Seedance fait (vraiment)

Oubliez les démos de Sora avec des chats qui marchent bizarrement.

Seedance 2.0 produit des séquences cinématiques avec audio intégré. Vous décrivez une scène, le modèle génère l'image, le son, les voix, la musique.

Le lip-sync fonctionne dans 8 langues avec une précision phonémique. Les personnages bougent les lèvres en synchronisation exacte avec le dialogue généré.

Le multi-plans est natif. Vous pouvez décrire une séquence complète — plan large, gros plan, contre-champ — et le modèle maintient la cohérence visuelle entre les plans.

Un point crucial : tout est généré en un seul passage. Pas de combinaison de plusieurs outils. Pas de montage en post.

Le progrès sur la physique est le changement le plus marquant.

La gravité fonctionne. Les tissus tombent correctement. L'eau se comporte comme de l'eau. La version 1.0 plafonnait à 5-8 secondes de vidéo cohérente.

Et les chiffres parlent d'eux-mêmes. En quelques jours, Seedance a provoqué une onde de choc boursière en Asie.

Huace Media et Perfect World ont pris 7 à 10 %. Chinese Online Entertainment Group a touché sa limite quotidienne de +20 %.

L'avantage ByteDance

Là où Seedance devient vraiment dangereux, c'est quand on regarde qui est derrière.

ByteDance, c'est TikTok. C'est aussi CapCut, utilisé par plus d'un milliard de personnes pour éditer de la vidéo. C'est une infrastructure de distribution que ni OpenAI, ni Google, ni personne en Occident ne peut égaler dans le domaine de la vidéo courte.

Seedance est même déjà intégré dans Jianying (le CapCut chinois) et sera bientôt disponible dans la version globale de CapCut.

Imaginez Seedance intégré directement dans CapCut.

N'importe qui pourrait produire du contenu de qualité studio depuis son téléphone. Sans caméra, sans équipe, sans budget.

Et contrairement à Sora d'OpenAI, Seedance n'applique pas de restrictions strictes sur la propriété intellectuelle.

Pas de blocage automatique quand vous essayez de générer quelque chose qui ressemble à un style existant.

Sauf que c'est justement ce qui a mis Hollywood en furie.

Disney a envoyé un cease-and-desist accusant ByteDance d'un "virtual smash-and-grab" de sa propriété intellectuelle.

Paramount a suivi.

La MPA a exigé l'arrêt immédiat des activités d'infraction. SAG-AFTRA (le syndicat des acteurs) a qualifié Seedance d'"attaque contre tous les créateurs du monde."

En 2023, c'était difficile de faire marcher quelqu'un. Maintenant je peux tout faire. Les avancées technologiques ont été exceptionnelles.

Le problème que personne ne veut voir

Seedance a une fonctionnalité qui a fait le tour des réseaux avant d'être retirée : la génération de voix à partir d'une simple photo.

Vous uploadez la photo de quelqu'un. Le modèle génère une vidéo de cette personne en train de parler, avec une voix synthétique réaliste.

ByteDance l'a suspendue après qu'un blogueur chinois a signalé que la voix était générée sans consentement.

La nouvelle politique exige désormais une vérification d'identité pour toute génération basée sur une personne réelle.

Mais le fait qu'elle ait existé, même brièvement, montre où on en est.

La technologie pour créer des faux parfaits existe. Elle est accessible. Et elle ne va pas disparaître parce qu'un bouton a été désactivé.

Le modèle est disponible en bêta. ByteDance a annoncé ce matin qu'il "respecte la propriété intellectuelle" et renforcera ses garde-fous.

On a beaucoup écrit sur la Chine et l'IA ces dernières semaines.

Mais ce qui se passe avec Seedance est différent.

Dans la vidéo IA, c'est la Chine qui mène. Et avec ByteDance comme distributeur, le reste du monde va le sentir très vite.

Seedance 2.0 vous impressionne-t-il plus que Sora ?

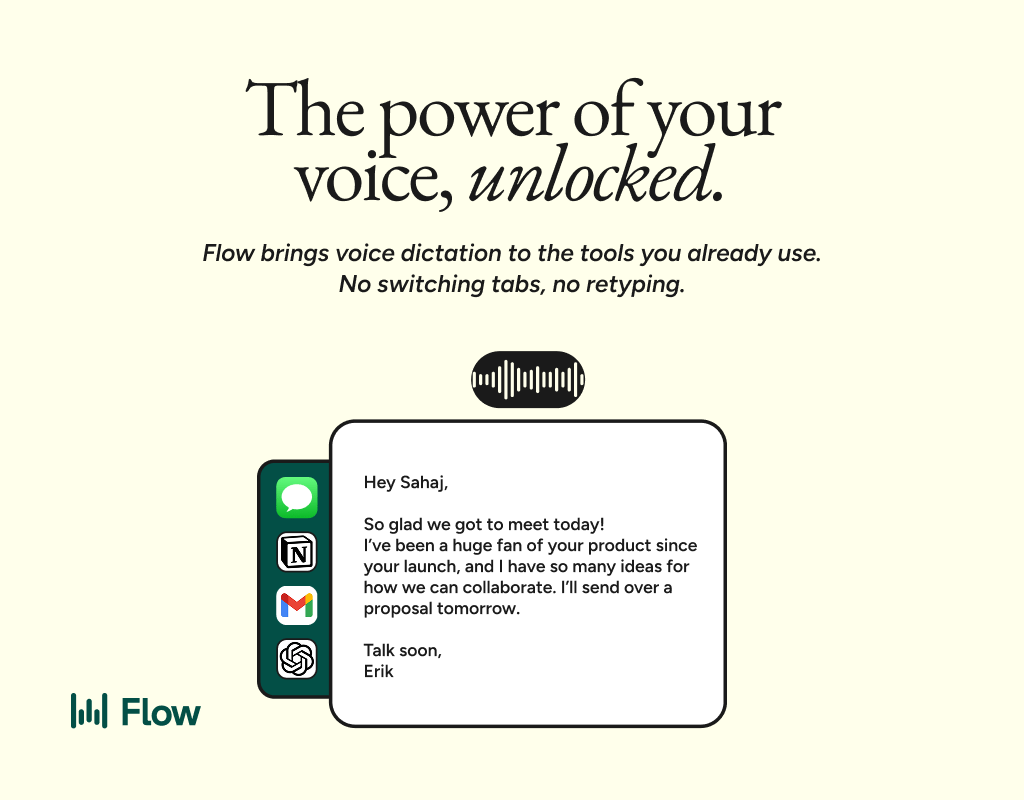

Better prompts. Better AI output.

AI gets smarter when your input is complete. Wispr Flow helps you think out loud and capture full context by voice, then turns that speech into a clean, structured prompt you can paste into ChatGPT, Claude, or any assistant. No more chopping up thoughts into typed paragraphs. Preserve constraints, examples, edge cases, and tone by speaking them once. The result is faster iteration, more precise outputs, and less time re-prompting. Try Wispr Flow for AI or see a 30-second demo.

PS : Cette newsletter a été écrite à 100% par un humain. Ok, peut-être 80%.