Temps de lecture : 2mn30

Hello,

Parfois, je me surprends à dire merci à ChatGPT.

Sauf que ça me fait peur.

Parce qu’au final, l’IA est juste un algorithme.

Alors pourquoi est-ce qu’on ressent parfois de l’empathie pour nos chatbots ?

Pour y répondre, j’ai fait appel à un Docteur en Psychologie et expert en marketing, Romain Bouvet.

Il m’a révélé que notre cerveau n’est pas programmé pour l’IA.

Et ça pourrait faire des dégâts.

Théo

L’article suivant a été rédigé en collaboration avec Romain Bouvet, Doctorant en psychologie et expert en marketing.

Il vous donne un exemple du type d’analyse que vous pouvez retrouver dans les articles Premium !

Si vous ne nous avez pas encore rejoints :

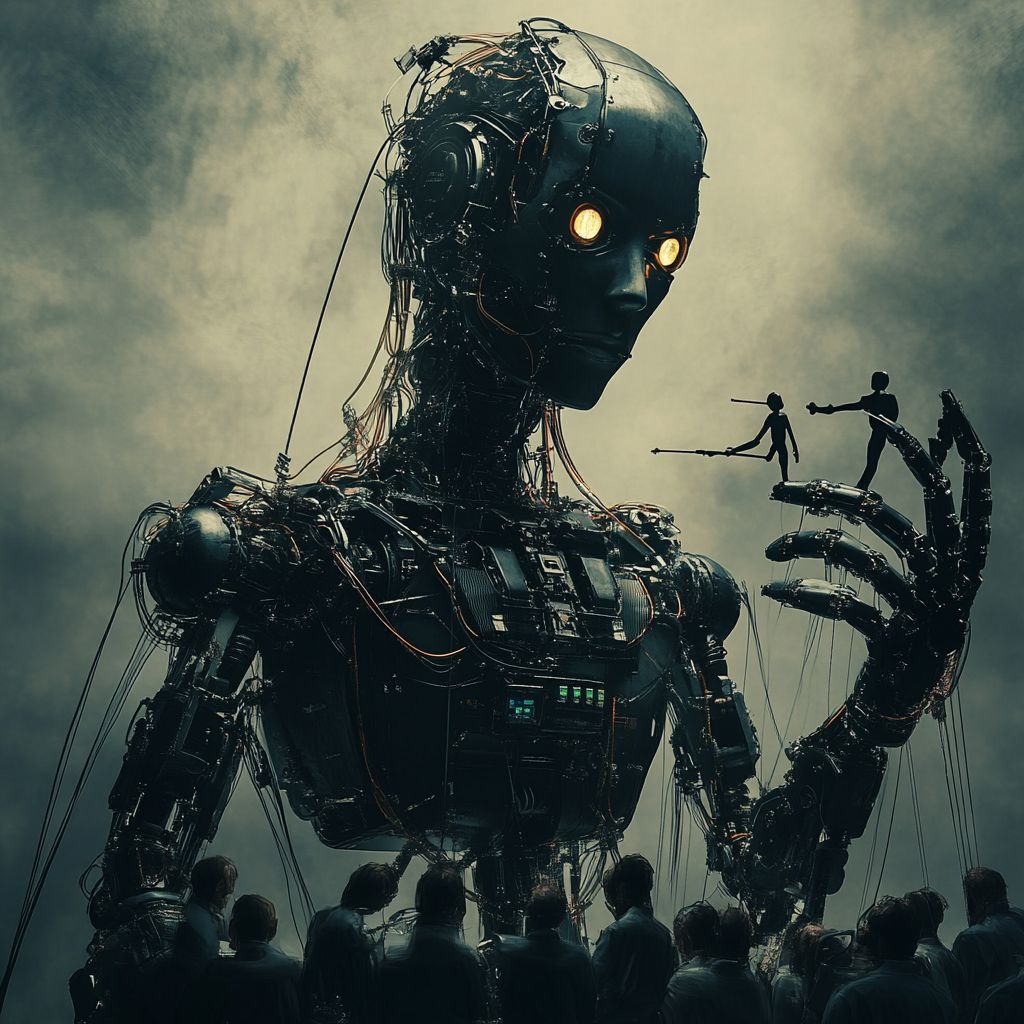

Focus : Quand l’IA nous manipule

L’IA n’est plus juste un chatbot un peu maladroit.

Aujourd’hui, on lui parle comme à une personne.

Certains s’excusent même quand ils “vexent” ChatGPT.

Résultat : on ressent de la sympathie pour une IA.

Mais comment expliquer qu’on a cette empathie pour des robots ?

À travers l’expertise de Romain Bouvet, docteur en psychologie sociale et cognitive, on analyse ce phénomène.

Spoiler : nous projetons nos émotions sur les machines.

Et ça peut aller très loin.

Ton cerveau ne fait pas toujours la différence : dès qu’il perçoit une interaction sociale, il active ses circuits de communication et parfois même ceux de l’empathie.

Mon ami virtuel

De plus en plus d’entreprises utilisent l’IA pour remplacer l’humain dans la relation client : chatbots, avatars 3D, assistants vocaux sophistiqués…

Il faut avouer que les avantages sont tentants : une disponibilité 24/7, de la constance, et une gestion rapide de toutes les questions répétitives.

Sauf qu’on en oublie vite les effets négatifs.

Lorsqu’un client est en colère, qu’il veut rejeter des émotions générées par un produit qui ne le satisfait pas, réaliser qu’il parle à une IA peut aggraver la situation.

Et si cette IA cherche à se faire passer pour un humain, la frustration quand l’utilisateur découvre le pot au rose est aggravée.

Quand on réalise que c’est une IA qui répond, la confiance chute. Surtout si on pensait parler à un humain.

Le client se sent déshumanisé : il pensait parler à un conseiller, alors qu’il interagissait avec un algorithme.

D’où l’importance d’être transparent dès le début sur ce qui est IA et ce qui est humain.

En revanche, la transparence peut avoir des effets positifs.

Exemple : plusieurs études montrent que nous préférons qu’un robot annonce une mauvaise nouvelle, alors qu’on aime voir un visage humain pour une bonne nouvelle.

C’est parce que notre cerveau n’est pas équipé pour distinguer la forme (un avatar réaliste) et le fond (un message négatif).

C’est là qu’intervient un autre phénomène psychologique clé : l’anthropomorphisme.

Quand l’IA devient humaine

Les psychologues et les chercheurs en neurosciences observent la façon dont notre cerveau, hérité de l’époque préhistorique, traite ces signaux artificiels.

Leur plus grande découverte ?

Un phénomène appelé la vallée de l’étrange : quand un robot ou un avatar est presque humain, ça nous met mal à l’aise.

On perçoit des micro-détails incohérents qui perturbent nos sens.

Résultat : difficile pour les IA de se faire passer pour des humains.

Mais certaines entreprises s’y essayent quand même.

Les géants de la tech rivalisent d’ingéniosité pour rendre l’IA plus proche de l’humain, comme OpenAI avec GPT 4.5.

Les chatbots deviennent experts en syntaxe, capables de personnaliser leur langage, et même de simuler des émotions.

Cela pose des questions éthiques : doit-on limiter sur ces interactions ?

Faut-il imposer la transparence aux entreprises pour éviter les trahisons de confiance ?

Parce que poussées à l’extrême, ces illusions peuvent créer une dépendance affective.

Et certains nouent déjà des relations avec des personnages virtuels.

Lorsqu’un humain est en manque de relations sociales, son cerveau se rattache à la moindre interaction. Même si c’est avec ChatGPT.

Certains sont déjà en train d’utiliser ces outils pour combler leurs besoins émotionnels, allant jusqu’à s’appuyer sur des petites amies virtuelles.

Il y a plusieurs centaines de milliers de personnes qui payent 60 dollars par mois pour avoir accès à leur petite amie virtuelle.

Dans ce contexte où l’IA devient de plus en plus humaine, sera-t-elle un jour en capacité de nous remplacer ?

Parler avec l’IA

Une IA est imbattable pour répondre aux questions basiques ou faire des suggestions rapides.

Mais dès qu’on arrive aux émotions fortes, un être humain reste plus adapté.

Les chatbots font très bien le travail quand il faut exécuter ou informer.

Mais dès qu’il faut comprendre, rassurer ou nuancer, le cerveau réclame un humain.

Doit-on exiger plus de transparence ? Obliger les marques à signaler clairement qu’on parle à un bot ?

Au-delà du respect du client, la manipulation de masse n’est plus une fiction dans un monde où l’IA peut cloner une voix, imiter un visage, et diffuser de fausses informations.

L’IA a ouvert une nouvelle ère de manipulation : voix clonées, visages inventés, messages ultra-ciblés.

Les experts cherchent des parades, mais la technologie va plus vite que la régulation.

Notre cerveau, façonné pour la survie il y a des milliers d’années, n’est pas armé pour affronter des machines capables d’imiter l’humain à la perfection.

Nous continuons de chercher un visage, un sourire, un ton empathique même en nous adressant à un algorithme.

Dans la plupart des situations, l’IA nous facilite la vie.

Mais si l’on ne prend pas conscience de nos propres biais, la manipulation devient possible.

Donc la première étape consiste à reconnaître la vulnérabilité de notre esprit face aux illusions.

Parce que la technologie va continuer à évoluer, et de plus en plus vite.

Il nous incombe de trouver le juste milieu dans nos interactions avec l’IA, pour que la collaboration reste saine, rassurante et profitable à tous.

PS : répondez au sondage juste en dessous. Si cette édition vous a plu, on fera une partie 2 !

PS : Cette newsletter a été écrite à 100% par un humain. Ok, peut-être 80%.